171. Newsletter - sicherheitskultur.at - 30.04.2021

von Philipp Schaumann

Hier die aktuellen Meldungen:

1. Artificial Intelligence Act, AI Act, die geplante Regulierung von Algorithmen (und AI) (Stand 7.6.2021)

Dieser Beitrag wird etwas länger, denn dieses Thema liegt mir persönlich sehr am Herzen, mögliche Regulierungen von algorithmischen Systemen ist ein Schwerpunkt bei meinen Vorlesungen zu "Algorithmen-Ethik".

In den letzten Wochen hat sich beim Thema 'Regulierung von Algorithmen (und AI)' einiges getan, sowohl in Brüssel als auch in den USA. Von der Leyen hatte bereits Ende 2019 angekündigt, dass diese Regulierung für sie eines der großen Themen in 2020 sein würde - aber das kam dann leider doch anders. Jetzt ist endlich ein erster Entwurf des sog. 'AI-Acts' draußen. Siehe auch artificialintelligenceact.eu.

|

| Leicht humorvoll wird hier die 'Begriffsverwirrung rund um AI' recht gut zusammengefasst. |

Einschub zur Begriffsklärung: Beide, EU und FTC, sind mit den Begriffen AI, Algorithmen, etc. recht großzügig, d.h. die Texte beziehen sich auf alles, was ein Computer tun kann, sofern dies Auswirkungen auf Menschen hat.

Die FTC in den USA wird aktiv

Parallel dazu hat die Konsumentenschutz- und Wettbewerbsbehörde der USA Federal Trade Comission (FTC) erklärt, dass sie in Zukunft gegen Software-Nutzer und Software-Anbieter vorgehen werden, deren Systeme Voreingenommenheit / Bias demonstrieren. Dies sind z.B. alle Algorithmen die bei schwarzer Hautfarbe anders reagieren als bei typisch europäischer Haut, und das sind nun mal nach heutigem Stand ALLE Gesichtserkennungssysteme. Oder Systeme und/oder Algorithmen, die Frauen oder Minderheiten benachteiligen weil diese Gruppen in den Trainingsdaten unterrepräsentiert waren. Beide US-Parteien waren bisher eher zögerlich bei Eingriffen in Märkte, jetzt stehen aber bei diesem Thema beide hinter der FTC.

Technology Review vermutet, dass die FTC sogar 'mehr Biss' haben könnte, denn sie brauchen keine neuen Gesetze oder Verordnungen. Wenn sie postulieren, dass 'etwas' zum Nachteil von Kunden oder Mitbewerbern ist, so können sie dagegen vorgehen und Beweise für Behauptungen der Hersteller verlangen. So hat sich die FTC schon oft für den Datenschutz stark gemacht, z.B. wenn ein Anbieter sich Vorteile verschafft indem er beim Datenschutz 'mogelt', z.B. mehr verspricht als er halten kann.

Gizmodo schreibt: FTC Says Racist Algorithms Could Get You In a Lot of Trouble. Hier jetzt einige bereits untersuchte Beispiele:

- Bereits 2016: Studien zu "automated sentencing" nach der Wahl von President Obama:

White House report on Big Data . . . cautions against re-encoding bias and discrimination into algorithmic systems. - Software used to predict future criminals is biased against blacks

- ProPublica 2016: What Algorithmic Injustice Looks Like in Real Life.

- 2020 Studien zu 'Compas-SW: Correctional Offender Management Profiling for Alternative Sanctions' und LSI-R (Level of Service Inventory-Revised)

- Bewerberauswahl durch AI: 2018: Der Amazon-Algorithmus diskriminierte gegenüber Frauen weil er auf der bisherigen Einstellungspraxis beruhte.

- 2021: Facebook's ad algorithms are still excluding women from seeing jobs (dabei es geht um Werbung auf FB und wem sie gezeigt wird, Frauen oder Männern oder beiden)

Die vorgeschlagene Algorithmen-Regulierung der EU

In der EU ist das mit der Regulierung etwas komplizierter. Aus Brüssel kam jetzt der lange erwartete Entwurf, er wird jetzt heftig kommentiert (und natürlich von einigen Industrievertretern bekämpft), dann überarbeitet werden und dann wird ein Kompromiss gesucht werden, mit dem ALLE Länder irgendwie leben können. Deswegen überrascht es wenig, dass die Formulierungen zwar weitreichend sind, aber auch offen für Interpretation.

Da steht z.B. das Verbot von 'subliminal techniques beyond a person's consciousness in order to materially distort a person's behaviour in a way that could cause psychological harm". Ich würde darin gern ein Verbot von personen-bezogener Werbung lesen und von Empfehlungsalgorithmen die auf eine Verstärkung von Emotionen hinzielen. Dies sehen einige Firmen natürlicherweise anders. Es werden auch 'specific vulnerable groups' erwähnt, bei denen es darum geht 'to materially distort their behavior' to cause 'psychological or physical harm.' Dies addressiert wohl explizit Werbung die z.B. für Personen geschaltet wird, die ein Problem mit Suchtverhalten haben oder 'Körperbildstörungen' (z.B. Bulimie, Anorexie). Hier ein Artikel von mir zu den zum Teil grauslichen Klassifizierungen.

Beim Einsatz von Biometrie wie Gesichtserkennung (aber da gibt es noch viel mehr, z.B. Erkennung am Gang) soll der Einsatz im öffentlichen Bereich für Echtzeitanwendungen verboten werden, nicht jedoch der nachträgliche Einsatz für die Aufklärung von Verbrechen. D.h. es darf immer weiter kräftig mit Kameras aufgezeichnet werden, auf Straßen, Plätzen, in Schulen, etc. Aber gerade beim Einsatz für die Verbrechensaufklärung ist es in den USA in den letzten Monaten zu schlimmen Problemen gekommen.

Hier Beispiele von Untersuchungshaft auf Grund von fehlerhafter Gesichtserkennung: Flawed Facial-Recognition System Sent This Man to Jail und Another Arrest, and Jail Time, Due to a Bad Facial Recognition Match.

Zur Job-Bewerbungsgespräche mit AI: Deutsche Bewerbungs-KI bevorzugt Jobsuchende mit Bücherregal im Hintergrund.

Zurück zum EU-Entwurf (auch Artificial Intelligence Act, AIA genannt)

Wenig überraschend gibt es in dem EU-Entwurf wieder jede Menge der leider üblichen Ausnahmen für nationale Sicherheit, etc. Sehr interessant finde ich die sehr weitreichende Definition von AI - nach der EU-Definition fallen auch einfache statistische Verfahren darunter, und zwar dann, wenn sie z.B. dazu dienen, Entscheidungen über Menschen zu Fällen, z.B. beim österreichischen Arbeitsamt AMS. Ich finde das gut, verwende aber lieber den Begriff 'Algorithmus', der dies m.E. besser beschreibt (siehe weiter oben die 'Begriffsverwirrung rund um AI'.

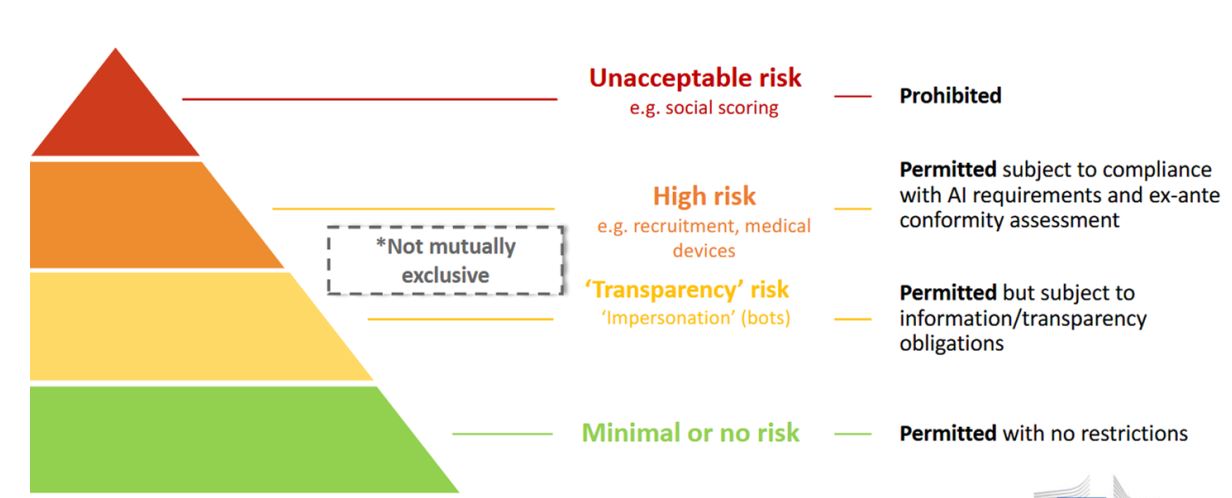

Alle Algorithmen werden in dem Entwurf in 4 Klassen eingeteilt, von 'Minimal Risk_ bis 'Unacceptable'. Für Algorithmen in der Klasse 'High Risk' müssen Firmen eine Risikoabschätzung vorlegen (wohl analog zur Nutzung von Gesundheitsdaten (und anderen sog. "sensiblen" Daten) in der DSGVO. Für solche 'quality management and conformity assessment procedures', gibt es bereits einen Vorschlag für einen Katalog von Kriterien, die erfüllt sein müssen (rechte Spalte des verlinkten Beitrags, ca. in der Mitte).

Das klingt soweit erst mal gut (für mich), vielen NGOs ist der Entwurf zu wage und bietet zu viele Auswege und Ausnahmen. Wir werden sehen, was bei der Diskussion zwischen Industrie-Lobbyisten, NGOs und den EU-Regierungen am Ende konkret übrig bleibt. Hal Faber von heise.de ist pessimistisch. Im fehlen klare "rote Linien", die im ersten Vor-Entwurf noch drin waren, nun aber leider rausgefallen sind. Er befürchtet Ethic-Washing, dann würde sich nicht viel ändern, aber die Firmen ihre Folgenabschätzung berufen.

So wie bei der DSGVO würde wohl auch diese EU-Regulierung Auswirkungen über die EU hinaus haben. Erstens wollen Firmen in der EU verkaufen, außerdem haben viele andere Regulierungsbehörden die Inhalte der DSGVO weitgehend übernommen. Dies könnte bei diesem Thema (hoffentlich) ähnlich werden.

|

| Hier die Darstellung der Risikostufen nach C.Wendehorst |

Der jetztige Vorschlag der EU lehnt sich an Produktsicherheitsrecht an und ist risiko-orientiert. D.h. die Regeln sind unterschiedlich je nach dem Risiko, das in gewissen Anwendungen gesehen wird.

Der Text der Verordnung liest sich (wie eigentlich alle diese EU-Texte) sehr sperrig. Als Einstieg empfehle ich daher die lesenswerte Zusammenfassung und Bewertung aus den USA: lawfareblog.com: What Is the European Approach for AI?, inkl. einer detaillierten Diskussion der komplexen Ideen zu Biometrie im öffentlichen Raum.

Ebenfalls hilfreich ist Christiane Wendehorst, die beim Konzept der deutschen Datenethik-Kommission (DEK) ein die einen ähnlichen Regulierungsvorschlag ausgearbeitet hatte. Hier ihre Slides: Vorläufige Analyse zum Vorschlag eines Artificial Intelligence Acts - Ihr Vortrag dazu.

|

| Hier die Darstellung der Risikostufen aus Lawfareblog |

Mich erinnern die Vorschläge für die High Risk Anwendungen stark die Vorgehensweie und die Fragen an die Vorschläge für Risikobewertungen wie sie im Bereich Datenschutz von den Behörden vorgeschlagen wurden, d.h. damit haben Firmen (hoffentlich) bereits Erfahrung.

Ich hoffe sehr, dass sich mit Hilfe dieser beiden Aktivitäten der Siegeszug des automatisierten Bewertens und Steuern von Menschen etwas einbremsen lassen lässt. Hier mehr zu Biometrie-Themen auf der sicherheitskultur.at.

Ein Beispiel eines Bewertungssystem das nach EU-Position klar unter "Verboten" fällt: Das Social Credit System in China. Die chinesische Regierung hat gerade von der Alibaba-Finanzsparte Ant Group alle Kundendaten angefordert, auf die hatte sie wohl bisher noch keinen Zugriff.

Hier der Link auf eine Fortsetzung mit einem Blick wie es in den USA und EU weitergeht und die immensen Lobbying-Aktivitäten.

2. RDP oder Cloud-Datenbanken als Eingangstor für (Ransomware-)Angriffe

Die Eingangstore für Ransomware-Angriffen sind vielfältig. Bisher war die Expertenmeinung, dass das 'Hereinfallen' auf Phishing Mails der Hauptpunkt sei.

Das FBI behauptet nun für die USA, dass 70-80% auf nicht ausreichend geschützte RDP-Zugänge zurückzuführen sind, die nicht über 2-Faktor-Login abgesichert sind. 1,3 Mio. solcher Zugangspassworte werden auf einem illegalen Marketplace angeboten. (RDP ist die gängigste 'Fernbedienungssoftware für Windows Server, solche Zugänge sollten NIE direkt im Internet stehen und dann noch einfach über Username/Passwort statt 2-Faktor-Login zu nutzen sein).

FBI has stated RDP is responsible for 70-80% of all network breaches leading to ransomware attacks. UAS, or 'Ultimate Anonymity Services,' is a marketplace that sells Windows Remote Desktop login credentials: What makes UAS stand out is that it is the largest such marketplace, performs manual verification of sold RDP account credentials, offers customer support.

Noch eine Meldung dazu: Logins for 1.3 million Windows RDP servers collected from hacker market

Und für alle Kriminellen, denen diese 1,3 Mio offenen Systeme nicht genug sind gibt es auch noch eine Liste von 2 Millionen Datenbanken in Cloud-Systemen. Der Artikel schreibt darüber, dass die administrativen Interfaces vieler Cloud-Angebote die Techniker auf der Nutzerseite überfordern (ob by-Design lässt der Artikel offen). Ergebnis sind die hier entdecken 2 Millionen offenen Systeme, aber auch die vielen fehlkonfigurierten Cloud-Systeme auf die ich früher bereits immer wieder hingewiesen habe. Außerdem hier noch mal das Cloud-Tutorial von heise.de.

Achtung: Satire zu Verkehrspolitik

Satire ist ein schwieriges Feld, aber diese Folge von Postings auf Twitter zum Thema Verkehrspolitik (speziell in Wien) finde ich lustig. Angeblich geht das gegen "rote" Verkehrspolitik, aber da könnten sich meiner Meinung nach auch noch viele andere Farben getroffen fühlen.

Ich fürchte, die Notwendigkeit einer drastisch anderen Verkehrspolitik ist noch bei sehr wenigen Politikern angekommen